التزييف العميق .. جبهة جديدة يفتحها الذكاء الاصطناعي

قبل يومين من الانتخابات السلوفاكية في سبتمبر، انتشر تسجيل غامض على نطاق واسع على وسائل التواصل الاجتماعي.

في التسجيل، يمكن سماع مرشح المعارضة الليبرالية ميشال شيميكا وهو يتآمر مع أحد الصحافيين لشراء الأصوات والتلاعب بالنتيجة.

"سنفعل ذلك بطريقة لا يمكن لأحد أن يتهمك فيها بتلقي رشا"، كما يزعم أن سيميكا يقول في التسجيل الصوتي، وفقا لنص المحادثة التي تم تداولها أيضا في ذلك الوقت. ويجيب الصحافي: "كن حذرا، هناك كثير من الأشخاص حولك، لا تستخدم كلمة "ر" (رشا).

وما يثير الصدمة بشأن التسجيل هو أنه كان مزيفا – خدعة متطورة تم إنشاؤها بواسطة الذكاء الاصطناعي، كما قال مدققو الحقائق، مستشهدين بمؤشرات مثل الإلقاء غير الطبيعي والتوقفات غير المعتادة.

ومع ذلك، تمت مشاركة التسجيل من قبل آلاف الناخبين خلال الوقف الذي فرضه البلد على تغطية الانتخابات، ما جعل من الصعب على حلفاء شيميكا أو وسائل الإعلام فضحه باعتباره مزيفا.

ندد شيميكا، الذي تصدر استطلاعات الرأي، بالتسجيل ووصفه بأنه "غباء هائل وواضح"، وأصدرت الشرطة السلوفاكية تحذيرا للناخبين بضرورة توخي الحذر عبر الإنترنت من الجهات الفاعلة الشائنة ذات "المصالح الخاصة". لكن شيميكا خسر في التصويت لمصلحة منافسه الشعبوي المؤيد لروسيا روبرت فيكو.

لا يزال الجناة مجهولين ومن المستحيل قياس التأثير الدقيق في النتيجة – لكن الحادثة أنذرت بفجر جديد لحرب المعلومات وتحد هائل لمنصات وسائل التواصل الاجتماعي في وادي السيليكون قبل عام تاريخي من الانتخابات. ومن المتوقع أن يتوجه ما يقدر بملياري شخص، أو نحو نصف السكان البالغين في العالم، إلى صناديق الاقتراع عام 2024، بما في ذلك في الولايات المتحدة، والاتحاد الأوروبي، والهند والمملكة المتحدة.

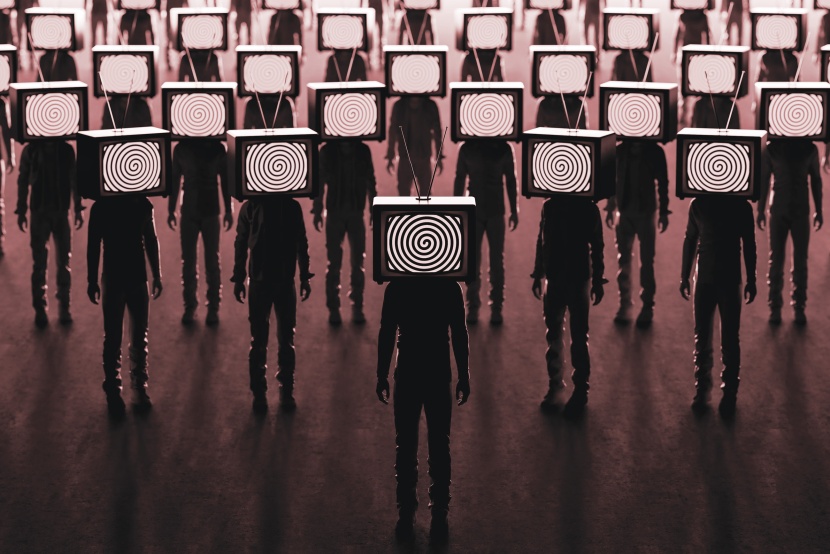

لقد كانت المعلومات المضللة عبر الإنترنت عاملا في الانتخابات لأعوام عديدة. لكن التطورات السريعة الأخيرة في تكنولوجيا الذكاء الاصطناعي تعني أن التلاعب بوسائل الإعلام أصبح أرخص وأسهل من أي وقت مضى، وذلك بفضل سوق جديدة نشطة من الأدوات القوية مثل برمجية شات جي بي تي من شركة أوبن أيه آي، أو شركة ميدجورني الفنية الناشئة في مجال الذكاء الاصطناعي، أو غيرها من مولدات النصوص والصوت والفيديو.

وفي الوقت نفسه، أصبح من الصعب على نحو متزايد اكتشاف الوسائط المتلاعب بها أو التخليقية.

وبالفعل، أصبحت عمليات التزييف العميق الواقعية جبهة جديدة في مشهد التضليل الإعلامي حول الصراع بين إسرائيل وحماس والصراع بين روسيا وأوكرانيا.

والآن، أصبحت على وشك تعكير صفو العمليات الانتخابية التي شوهت بالفعل بسبب تضاؤل ثقة الجمهور في الحكومات، والمؤسسات والديمقراطية، إلى جانب النزعة الليبرالية الكاسحة والاستقطاب السياسي.

يقول هنري أجدر، خبير الذكاء الاصطناعي والتزييف العميق ومستشار شركات أدوبي، وميتا وآي واي: "لقد وصلت التكنولوجيات إلى هذه الثلاثية المثالية من الواقعية، والكفاءة وإمكانية الوصول. لقد كانت المخاوف بشأن التأثير الانتخابي مبالغا فيها حتى هذا العام. ثم حدثت الأمور بسرعة لا أعتقد أن أحدا كان يتوقعها".

تصدر السلطات بالفعل تحذيرات. ففي المملكة المتحدة في نوفمبر، أثارت مكاتب الاتصالات الحكومية البريطانية احتمالية إنشاء "حسابات مزيفة شديدة الواقعية بواسطة الذكاء الاصطناعي" وحملات تزييف عميقة متقدمة بشكل متزايد قبل الانتخابات في البلد. واقترحت مجموعة من أعضاء مجلس الشيوخ الأمريكي من الحزبين أخيرا تشريعا يحظر استخدام "الإعلانات السياسية المخادعة بشكل كبير التي ينتجها الذكاء الاصطناعي".

وتواجه منصات وسائل التواصل الاجتماعي، بما في ذلك ميتا، ومنصة يوتيوب التابعة لشركة جوجل، وتيك توك وإكس، الآن ضغوطا لإدخال حواجز حماية حول التزييف العميق، وكبح الجهات الفاعلة الشائنة والتأكد من قيامها بإجراء دعوات الاعتدال الصحيحة عندما يتعلق الأمر بوسائل الإعلام الغامضة للغاية، مع البقاء في الوقت نفسه غير منحازة.

لكن الخبراء يحذرون من أن كثيرين منها أقل تجهيزا للقيام بذلك مما كانت عليه في الانتخابات الكبيرة السابقة. قلص البعض، بما في ذلك شركة ميتا، استثماراتهم في الفرق المخصصة للحفاظ على انتخابات آمنة بعد تراجع أسهم التكنولوجيا أوائل عام 2023. وفي حالة منصة إكس لإيلون ماسك، فقد تم تقليص موارد الإشراف على المحتوى بشكل كبير حيث تعهد باستعادة ما يسميه بحرية التعبير المطلقة.

كما أصبحت جهود مجموعات التكنولوجيا التي تتخذ من الولايات المتحدة مقرا لها للاستثمار في التدقيق في الحقائق ومعالجة المعلومات المضللة مسيسة، حيث يتهمها السياسيون الأمريكيون اليمينيون بالتواطؤ مع الحكومة والأكاديميين لفرض رقابة على الآراء المحافظة.

يحذر كثير من خبراء وأكاديميين مختصين في المعلومات المضللة ذوي الميول اليسارية من أن هذه الديناميكية تجبر المنصات، والجامعات والوكالات الحكومية على الانسحاب من مبادرات نزاهة الانتخابات والتعاون على مستوى العالم خوفا من الانتقام. وقالت شركة ميتا في ديسمبر: إن الحكومة الأمريكية أوقفت تبادل المعلومات مع المنصة، رغم أن مثل هذا التعاون ساعد الشركة في السابق على تحديد "جهات التهديد المتطورة".

ويحذر كثيرون من أن هذا المزيج السام من أدوات الذكاء الاصطناعي المتطورة وتدابير الوقاية الأقل قوة يعني أن ما يصفه الخبراء بسيناريو يوم القيامة المتعلق بالمعلومات المضللة – وهو أن التزييف العميق المنتشر على نطاق واسع الذي لا يمكن اكتشافه سيكون له تأثير كارثي في العملية الديمقراطية – لم يعد مجرد أمر نظري.

ويقول رئيس أحد مراكز الأبحاث الرقمية غير الهادفة للربح: "أعتقد أن الجمع بين الفوضى التي ستمكنها أدوات الذكاء الاصطناعي التوليدي وعيوب البرامج التي وضعتها المنصات لضمان نزاهة الانتخابات هو الكارثة التي تتكشف أمام أعيننا. إنني قلق للغاية من أن الضحية ستكون الديمقراطية نفسها".

لقد تم طرح فكرة حروب المعلومات المضللة عبر الإنترنت في الوعي العام في أعقاب فوز دونالد ترمب في الانتخابات الرئاسية الأمريكية عام 2016.

بحلول عام 2020، كانت حملات التضليل على وسائل التواصل الاجتماعي قد عملت في أكثر من 80 بلدا، وفقا لمعهد أكسفورد للإنترنت – التي نظمتها بشكل مختلف الأحزاب السياسية، والعلاقات العامة الغامضة ومجموعات استخبارات القطاع الخاص، أو الحكومات نفسها. وبدأ البعض في تجربة تكنولوجيات التزييف العميق البدائية، خاصة العروض الرقمية للوجوه الوهمية.

ردا على ذلك، قدمت شركات جوجل، وميتا، وتيك توك وإكس قواعد تحظر عمليات التأثير السرية المنسقة والمعلومات الخاطئة حول التصويت وقمع الناخبين. وتحظر شركة جوجل الوسائط المتلاعب بها والمتعلقة بالسياسة والقضايا الاجتماعية، بينما حظرت شركة ميتا المحتوى المتلاعب به والمصمم للتضليل، وتسمح لمدققي الحقائق التابعين لها بالإبلاغ عما إذا تم "تغيير" الوسائط، ما يجعلها أقل بروزا في المحتوى الذي يراه المستخدمون.

لكن ظهور الذكاء الاصطناعي التوليدي – نماذج قوية متعددة الوسائط يمكنها مزج النصوص، والصور، والصوت والفيديو – أدى إلى تحويل جذري في إمكانات التزييف العميق، ما جعل القدرة على إنشاء وسائط مقنعة على نطاق واسع في متناول أي شخص تقريبا.

تسمح الشركات الناشئة في مجال إنشاء مقاطع الفيديو، مثل هايجين ومقرها لوس أنجلوس وسينثيزيا ومقرها لندن، التي تلبي عادة احتياجات صناعات مثل الأفلام والإعلانات، تسمح للعملاء بإنشاء مقاطع فيديو أمام صور رمزية للذكاء الاصطناعي مقابل ما يزيد قليلا على 20 دولارا شهريا، في سوق سريعة النمو بلغت قيمتها بالفعل نحو نصف مليار دولار عام 2022. وكذلك يمكن استخدام التكنولوجيا لإنشاء مقالات إخبارية مدعومة بالذكاء الاصطناعي، أو تشغيل مواقع إخبارية، أو أتمتة جيوش من الروبوتات، أو حتى إنشاء روبوتات دردشة يمكنها الكتابة لحشد مشاعر سياسية معينة لدى المستخدم في النهاية.

يقول بريان ليستون، محلل استخبارات في المجموعة السيبرانية ريكورديد فيوتشر: "لقد كان عام 2023 بمنزلة التمهيد لما سنراه [هذا] العام عندما نتحدث عن وسائل الإعلام التي تم التلاعب بها والتأثير المدعوم بالذكاء الاصطناعي... سواء من جانب جهات فاعلة فردية أو ربما مؤسسات الدولة القومية".

لقد تم تداول تسجيل صوتي مزيف عميق لزعيم المعارضة البريطاني كير ستارمر وهو يوبخ مساعديه في اليوم الأول من مؤتمر حزب العمال في أكتوبر. وقام موقع يوتيوب التابع لشركة جوجل العام الماضي بتعليق عدة حسابات في فنزويلا تعرض مقاطع فيديو لمذيعي أخبار زائفين يقرأون معلومات مضللة تلقي الضوء على نظام الرئيس نيكولاس مادورو بشكل إيجابي.

تختلف دوافع الحملات. حيث يتم تصميم بعضها للتأثير في الرأي أو تشويه سمعة المرشحين. ويسعى آخرون إلى تقويض الثقة في الديمقراطية كجزء من أهداف جيوسياسية أوسع وأكثر استراتيجية. ثم هناك أولئك الذين يحاولون فقط تحقيق التفاعل والربح، عبر النقرات الإعلانية على سبيل المثال.

وهناك أيضا آثار ثانوية. مثلما استخدم بعض السياسيين مثل ترمب مفهوم "الأخبار المزيفة" كسلاح عبر وضع المصطلح على الروايات التي يختلفون معها، كذلك يمكن استخدام الوعي العام المتزايد بالتزييف العميق لتشويه الحقائق وإنكار الواقع.

بالفعل، يعد ادعاء أن شيئا ما مجرد تزييف عميق تكتيكا تستخدمه الفرق القانونية للدفاع عن عملائها. ففي العام الماضي، أشار محامو إيلون ماسك أن مقطع الفيديو على موقع يوتيوب حيث يتحدث رجل الأعمال الملياردير عن قدرات القيادة الذاتية لشركة تسلا قد يكون مزيفا، كجزء من دعوى قضائية بشأن وفاة رجل استخدم النظام. وقال القاضي إن هذا ليس سببا لرفض الأدلة، ووصف الحجة بأنها "مثيرة للقلق".

وفي المجال السياسي، أصبح لدى المرشحين الآن "القدرة على رفض أي مقطع صوتي أو فيديو ضار"، كما يقول بريت شيفر، خبير الدعاية في التحالف من أجل تأمين الديمقراطية، وهو جزء من مؤسسة صندوق مارشال الألماني البحثية. تم توضيح هذا المفهوم، المعروف باسم "مكسب الكاذب"، لأول مرة في ورقة أكاديمية عام 2018 تقول إن "التزييف العميق يجعل من السهل على الكذابين تجنب المساءلة عن الأشياء التي هي في الواقع صحيحة".

كما تظهر الأبحاث أن مجرد وجود التزييف العميق يؤدي إلى تعميق عدم الثقة في كل شيء عبر الإنترنت، حتى لو كان حقيقيا. يقول شيفر، في السياسة، "هناك ميزة استبدادية لمهاجمة فكرة وجود شيء اسمه الحقيقة الموضوعية".

"يمكنك أن تجعل الناس يصلون إلى حد اعتقادهم أن التصويت لا يهم. لأن الجميع يكذب علينا. يتم تنظيم كل هذا. لا يمكننا التحكم في أي نتائج هنا". وهذا يؤدي إلى تراجع كبير ونشاط اجتماعي.

شركات التواصل الاجتماعي تحاول إنشاء حواجز حماية لهذا النوع الجديد من النشاط.

لقد أعلنت كل من شركتي ميتا وجوجل أخيرا سياسات تتطلب من الحملات الكشف عما إذا كانت إعلاناتها السياسية قد تم تغييرها رقميا. وتتطلب شركة تيك توك أن يتم الكشف بوضوح عن الوسائط الاصطناعية أو التي تم التلاعب بها التي تعرض مشاهد واقعية عبر ملصق، أو شرح توضيحي أو عنوان فرعي. وتحظر الوسائط الاصطناعية التي تضر بشخصيات خاصة حقيقية أو شخصية عامة إذا تم استخدامها للمصادقات، مثل عمليات الاحتيال.

وفي الوقت نفسه، تقول شركة إكس: إنها ستقوم إما بتصنيف أو إزالة الوسائط الخادعة التي تم التلاعب بها حيث تسبب الضرر، بما في ذلك التسبب في بلبلة حول الاستقرار السياسي.

لكن منع هذا النوع من الوسائط من النشر والمشاركة أصبح أكثر صعوبة، حتى بالنسبة لشركات مثل تيك توك وميتا التي استثمرت في قدرات الكشف والتتبع عالية الجودة.

تعد السرعة والاستجابة في الوقت الفعلي أمرا أساسيا. إذا كانت الثقة في صحة السرد واسع الانتشار مهزوزة، وكانت المنصات بطيئة في الاستجابة، فإن هذا يترك فراغا معرفيا خطيرا، كما يقول أجدر، "لتدخل الجهات الفاعلة سيئة النية ووسائل الإعلام الأقل دقة – خاصة وسائل الإعلام المتحيزة – لملء هذا الفراغ مع الإثبات".

لكن بينما ركز الباحثون الأكاديميون وفرق الإشراف سابقا على اكتشاف التناقضات في الوجوه التي يولدها الذكاء الاصطناعي، كما تقول رينيه ديريستا، مديرة الأبحاث في جامعة ستانفورد، فإنهم بدأوا الآن مرة أخرى من الصفر باستخدام كثير من أحدث تكنولوجيات الذكاء الاصطناعي التوليدي. وتقول: "إن تكنولوجيات الكشف عن الوجوه المزيفة ليست ذات صلة بإبداعات نماذج الانتشار الأحدث".

في الأمثلة السابقة للتزييف الذي تم إنشاؤه، كانت ملامح الوجه "تصف داخل شبكة"، كما تقول ديريستا، وكان من السهل اكتشاف الحالات الشاذة. يمكن للتزييف العميق البشري اليوم أن يتخذ أي وضعية، ويتحرك بشكل يبدو طبيعيا. "هناك ديناميكية عدائية مستمرة حيث تتحسن التكنولوجيا قبل تكنولوجيا الكشف. إنها مشكلة الملكة الحمراء - فنحن نجري بأسرع ما يمكن للبقاء في المكان نفسه".

يتفق الخبراء على أن أدوات الكشف الحالية ليست دقيقة عموما بما يكفي لتكون حماية موثوقة ونهائية. يقول ليستون: "التباين في النسبة المئوية للاكتشاف موجود في كل مكان وهناك تناقضات".

إضافة إلى ذلك، يجب أن تستمر المنصات في ضبط السياسات حول كيفية التعامل مع تلك التزييفات العميقة إذا تم اكتشافها. "هل تمسح هذا المحتوى؟ هل تعطيه اسما؟ هل تقلل من مدى الوصول؟" تقول كاتي هارباث، مسؤولة الشؤون العالمية في دوكو إكسبرتس ومديرة السياسة العامة السابقة في شركة ميتا.

وهي تشير إلى أن المنصات ستحتاج إلى فروق دقيقة في سياساتها للتمييز بين الاستخدامات الحميدة العديدة للذكاء الاصطناعي، مثل الحملة التي ترغب في استخدامه لإنشاء خلفية معينة لإعلان ما، والاستخدامات الشائنة.

ثم هناك مجالات أكثر ضبابية، مثل كيفية التعامل مع الهجاء أو المحاكاة الساخرة. أخذ إعلان هجوم على رون ديسانتيس في يوليو منشورات ترمب المكتوبة على منصته الاجتماعية الخاصة تروث سوشال واستخدم الذكاء الاصطناعي لإنشاء صوت يشبه ترمب يقرأها. هل ينبغي أن تكون هذه الأمور مقبولة؟ يقول حرباث: "أعتقد أن هذه بعض الأسئلة التي لا تزال مفتوحة حول كل هذا، والتي بدأت تصبح صعبة حقا، لأن الشيطان يكمن في تفاصيل تعريف كل هذا".

توصيف الفيديو

إضافة إلى التحري، تستكشف عديد من المنصات استخدام العلامات المائية أو مؤشرات أخرى لوضع توقيع المصداقية على المحتوى قبل نشره. إذ تقدم كل من جوجل وميتا علامة مائية غير مرئية للمحتوى الذي يتم إنشاؤه بواسطة أدوات الذكاء الاصطناعي الخاصة بهما.

لكن المشككين يشيرون إلى أن هذا عمل ما زال يجري، ولن يكون حلا فعالا إلا إذا تم تكييفه على نطاق واسع وبشكل مستمر. وقد تحدث نيك كليج، رئيس الشؤون العالمية في ميتا، علنا عن الحاجة إلى معايير صناعية مشتركة، بينما قالت تيك توك: إنها تقيم خيارات التحالف حول مصدر المحتوى.

ويقول الخبراء: إن حملات التضليل حولت انتباهها إلى الشركات التي تتخذ نهجا أقل صرامة تجاه الإشراف على المحتوى. وعلى وجه الخصوص، تعد منصتا تيليجرام وإكس المكانين اللذين "تنشأ فيهما كثير من هذه الأشياء الآن، لأن الجناة يعرفون أن المنصات القديمة تستثمر الموارد في هذا"، كما يشير هارباث.

وقالت إكس: إنها "مجهزة جيدا للتعامل" مع الوسائط التوليفية والمتلاعب بها، وأشارت إلى برنامجها التطوعي التثبت من الحقائق، المسمى كوميونيتي نوتس. كما قالت تيليجرام: إنها دخلت في شراكة مع وكالات التثبت من الحقائق لإضافة ملصقات إلى المحتوى المضلل المحتمل والمعلومات الصحيحة عبر قنواتها، مضيفة أنها تعتقد أن الطريقة الأكثر فاعلية لمكافحة المعلومات المضللة هي "نشر المعلومات التي تم التحقق منها".

وحتى داخل المنصات الأكبر حجما، يمكن أن تكون الموارد المخصصة لمعالجة المعلومات المضللة ونزاهة الانتخابات محدودة للغاية أو أنها ذات أولوية أقل في مناطق جغرافية معينة. حيث كان هذا أحد الانتقادات الرئيسة التي وجهتها إلى ميتا فرانسيس هوجين المختصة في الكشف عن الفساد في أكتوبر عام 2021. فقد سربت هوجين وثائق داخلية إلى وسائل الإعلام تظهر أن البلدان غير الناطقة باللغة الإنجليزية لديها عدد قليل من المشرفين، على سبيل المثال.

ويحذر أجدر قائلا: "إن جودة التنظيم الخاص بك تكمن في قدرتك على إنفاذه. عندما لا تكون هناك طريقة ذات معنى يمكن للمنصات من خلالها اكتشاف المحتوى الذي تم إنشاؤه باستخدام الذكاء الاصطناعي بشكل موثوق على نطاق واسع، وأيضا عندما يكون هناك كثير من المحتوى الحميد الذي يولده الذكاء الاصطناعي، فمن المشكوك فيه ما إذا كانت هذه السياسات... ستحدث في الواقع فرقا كبيرا".

لكن بعض المنصات لا تزال غير آبهة لذلك. حيث كتبت شركة ميتا في تقرير صدر في نوفمبر: "يحتاج مجتمع المدافعين في مجتمعنا إلى الاستعداد لحجم أكبر من المحتوى الاصطناعي" في عام 2024. لكنها أضافت أنها لا تعتقد أن ذلك "سيقوض جهود صناعتنا لمواجهة عمليات التأثير السرية".

وبالنسبة للبعض، فهناك بصيص أمل مختلف: أن أزمة المصداقية ستعود لسابق عهدها في نهاية الأمر، مع عودة الناخبين إلى المؤسسات القديمة وليس إلى منصات وسائل التواصل الاجتماعي للحصول على معلوماتهم. ويقول شيفر: "إذا كنت متفائلا بهذا الصدد، فأملي خلال خمسة أعوام، أن يعيد هذا الناس إلى وسائل الإعلام الآمنة والموثوقة وذات المرجعية".

لكن بالنسبة للآخرين، يبدو المستقبل قاتما إذا لم نتمكن من تصديق ما تخبرنا به أعيننا وآذاننا. لن يؤخذ أي شيء على ظاهره؛ فكل شيء سيتم استجوابه؛ وستصبح الديمقراطية أكثر هشاشة.

ويقول نيكولاس مولر، عالم أبحاث التعلم الآلي في فراونهوفر آيزك: "التكنولوجيا موجودة لتبقى وستصبح جيدة جدا. ربما لن تتمكن أنت من الوثوق بالوسائط مثل الصوت أو الفيديو فقط. فهذا سيحتاج إلى نقلة نوعية في رؤوسنا. وربما، مثل كوفيد، علينا فقط أن نتعايش معها".